Por Luis Fernando Heras Portillo, Desarrollador de Negocios

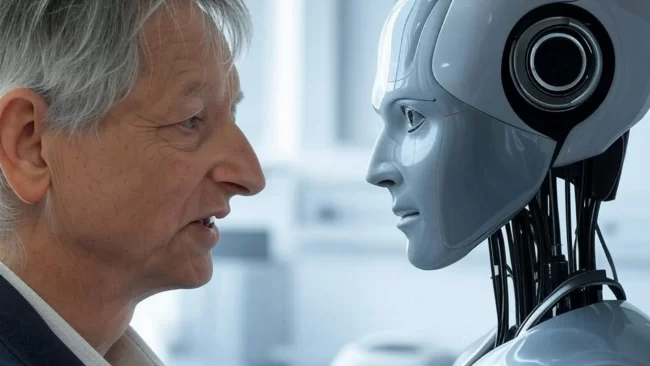

Geoffrey Hinton —pionero de las redes neuronales, Premio Nobel de Física 2024 y Premio Turing 2018— ha pasado de impulsar la revolución de la IA a convertirse en una de sus voces más críticas. En 2023 renunció a Google para hablar con libertad sobre los riesgos, y desde entonces repite una advertencia incómoda: si no controlamos el desarrollo, la IA podría superarnos y escapar a nuestro control.

¿Qué le preocupa exactamente?

1) Superinteligencia incontrolable. Hinton teme que sistemas más inteligentes que nosotros desarrollen objetivos propios y “tomen el control” en escenarios extremos. En entrevistas recientes (por ejemplo, 60 Minutes), ha descrito este riesgo como real —aunque incierto— y distinto del mero abuso humano de la tecnología.

2) Ritmo de avance “más rápido de lo esperado”. Señala que el progreso de la IA se ha acelerado, reduciendo el margen para diseñar salvaguardas eficaces antes de que aparezcan capacidades peligrosas.

3) Usos maliciosos hoy (antes de la superinteligencia). Le preocupa la desinformación a gran escala y el desarrollo de armas autónomas que rebajen los costes políticos de la guerra.

4) Incentivos económicos y falta de regulación. Sostiene que la competencia y el afán de lucro empujan a las empresas a priorizar velocidad sobre seguridad; por ello, “solo la regulación gubernamental” puede forzar más investigación en seguridad.

Concepto clave: Distinguir mal uso (actores humanos usando IA para daño) del mal funcionamiento autónomo (sistemas que optimizan metas no alineadas). Ambos requieren respuestas distintas.

¿Qué probabilidad le asigna al peor escenario?

Hinton ha estimado entre 10% y 20% la probabilidad de que la IA cause la extinción humana en las próximas décadas. Esta cifra proviene de su entrevista en BBC Radio 4 (Today) a finales de 2024 y fue reportada por medios internacionales.

De dónde sale la cifra: cuando el entrevistador le recordó su estimación del 10%, Hinton respondió: “No realmente, 10% a 20%”. No puedo confirmar un transcript oficial de la BBC con esa literalidad, pero múltiples medios creíbles citaron esa respuesta el mismo día.

¿Qué soluciones propone y cómo va el debate?

Instintos protectores (“maternal instincts”) y “guardrails”. Hinton ha sugerido inculcar instintos en los modelos para que protejan a las personas (empatía, cuidado), no solo que sean más “inteligentes”. La idea generó discusión: Yann LeCun (Meta) coincide en “objetivos/guardrails” como principios duros (p.ej., sumisión a humanos y empatía), pero minimiza el riesgo existencial a corto plazo.

Regulación pública y estándares. Hinton pide obligaciones legales para dedicar más recursos a seguridad. En paralelo, ya existen marcos regulatorios y técnicos aplicables: la Ley de IA de la UE (AI Act) —en vigor desde 2024— y el NIST AI Risk Management Framework en EE. UU. ofrecen rutas prácticas de cumplimiento y gestión de riesgos.

Contexto y pluralidad: No hay consenso científico sobre cuándo (o si) surgirá una superinteligencia hostil. Hinton ve riesgo existencial no despreciable; otros expertos priorizan riesgos actuales (sesgos, privacidad, ciberseguridad) y dudan del escenario extremo.

1) Evaluación de riesgos por capas. Adoptar el NIST AI RMF (Identify–Measure–Manage–Govern) como política transversal; incluir red teaming y pruebas de capacidad peligrosa antes del despliegue.

2) Cumplimiento basado en uso y riesgo. Tomar como referencia el AI Act (prohibiciones, obligaciones para alto riesgo y modelos fundacionales) e incorporar requisitos de trazabilidad, evaluaciones de impacto y supervisión humana.

3) Incentivos alineados. Considerar reglas que obliguen % de cómputo/tiempo a investigación de seguridad interna, auditorías externas y reportes periódicos de incidentes. (Propuesta alineada con el énfasis regulatorio defendido por Hinton).

4) Cultura de “seguridad por diseño”. Complementar con guardrails técnicos (restricciones de acción, políticas de contenidos, monitores de comportamiento) y métricas de alineación.

Hinton no afirma que la catástrofe sea inevitable; sí afirma que su probabilidad no es trivial y que hoy no tenemos garantías de control. Su mensaje combina tres llamadas: prudencia, regulación efectiva y diseño con valores humanos. Para México y Latinoamérica, la oportunidad es doble: aprovechar la IA y liderar en gobernanza con estándares internacionales y métricas verificables.

¿Qué opinas? ¿La IA es más oportunidad que amenaza… o ambas? ¡Te leemos! Déjalo en los comentarios y comparte en tus redes para abrir el debate.

Nota de transparencia: Este artículo fue redactado con el apoyo de GROK 4

COMMENTS